O viés em machine learning ocorre quando um modelo aprende padrões distorcidos dos dados, levando a previsões imprecisas ou discriminatórias. Esse fenômeno pode surgir por diversas razões, como uma base de dados mal selecionada, características ignoradas ou até mesmo o próprio algoritmo amplificando desigualdades existentes. O viés não só compromete a eficácia do modelo, mas também pode gerar impactos éticos, sociais e legais significativos.

Neste artigo, vamos explorar os principais tipos de viés em aprendizado de máquina, com exemplos práticos e estratégias para mitigá-los, garantindo que seus modelos sejam mais justos, precisos e confiáveis.

1. Viés de Amostragem (Sampling Bias)

O viés de amostragem ocorre quando os dados usados para treinar um modelo não representam adequadamente a população real, resultando em previsões enviesadas.

Imagine um modelo de crédito treinado apenas com dados de clientes de alto poder aquisitivo. Esse modelo pode classificar erroneamente pessoas de baixa renda como inaptas para crédito, simplesmente porque o conjunto de treinamento não continha exemplos suficientes desse perfil.

Como evitar?

- Diversifique a base de dados: Certifique-se de que os dados de treinamento sejam representativos da população alvo.

- Use técnicas de amostragem: Métodos como estratificação ou sobreamostragem (oversampling) podem ajudar a equilibrar os dados.

- Validação cruzada: Utilize técnicas como k-fold cross-validation para garantir que o modelo generalize bem para diferentes subconjuntos de dados.

2. Viés de Seleção (Selection Bias)

O viés de seleção surge quando os dados usados para treinar ou avaliar o modelo são escolhidos de forma enviesada, excluindo grupos ou cenários relevantes.

Um sistema de recomendação de produtos que só considera clientes antigos pode gerar sugestões irrelevantes para novos consumidores, reduzindo a taxa de conversão e a satisfação do cliente.

Como evitar?

- Analise critérios de seleção: Verifique se os dados excluem grupos importantes ou cenários críticos.

- Teste com diferentes segmentos: Avalie o desempenho do modelo em diversos subgrupos para garantir que ele generalize bem.

- Coleta de dados inclusiva: Certifique-se de que o processo de coleta de dados abrange todos os grupos relevantes.

3. Viés de Exclusão (Exclusion Bias)

O que é?

O viés de exclusão ocorre quando variáveis importantes são deixadas de fora do modelo, prejudicando a qualidade das previsões.

Se um modelo de previsão de churn ignora clientes que cancelaram o serviço nos primeiros dias, ele pode falhar em identificar padrões críticos que levam ao cancelamento, como problemas iniciais de usabilidade.

Como evitar?

- Revisão de variáveis: Analise cuidadosamente as variáveis utilizadas no modelo para garantir que todos os fatores relevantes estejam sendo considerados.

- Engenharia de features: Inclua variáveis que capturem aspectos importantes do problema, mesmo que pareçam menos óbvias.

- Análise exploratória: Realize uma análise exploratória detalhada dos dados para identificar possíveis variáveis omitidas.

4. Viés de Sobrevivência (Survivorship Bias)

O viés de sobrevivência ocorre quando apenas casos “bem-sucedidos” são analisados, ignorando aqueles que falharam. Isso pode levar a conclusões distorcidas e modelos pouco realistas.

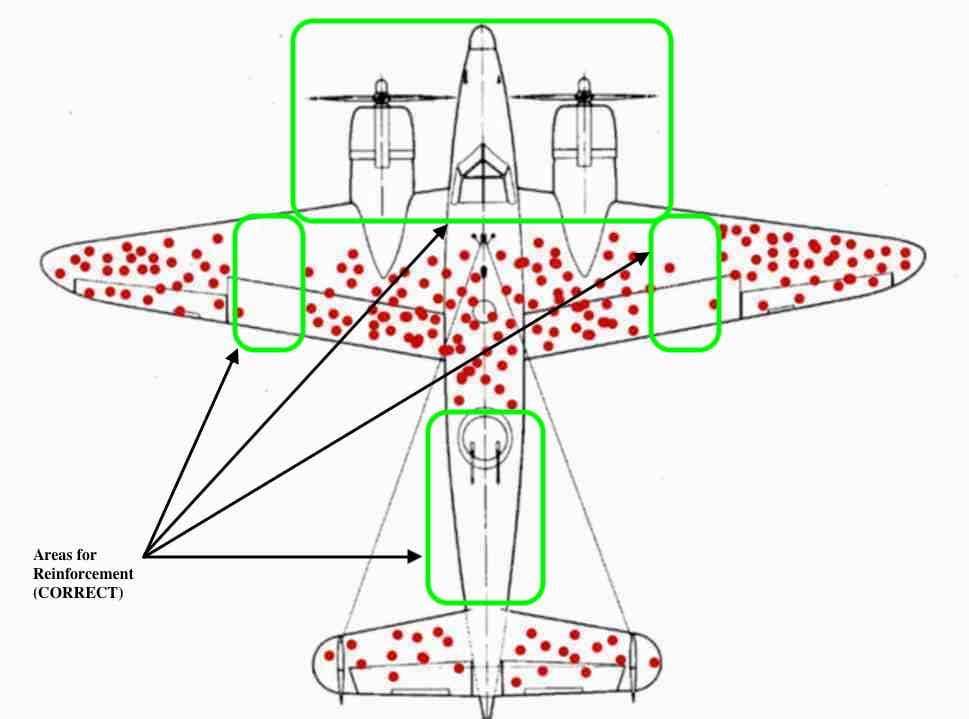

Durante a Segunda Guerra Mundial, os EUA enfrentavam dificuldades com seus bombardeiros no Pacífico e decidiram reforçar a blindagem em pontos estratégicos das aeronaves. Para isso, analisaram os danos nos aviões que retornavam de missões e concluíram que deveriam fortalecer áreas como a cauda, o corpo e as asas.

Porém, o estatístico Abraham Wald identificou uma falha nesse raciocínio: ao focar apenas nos aviões que conseguiram voltar, ignoravam aqueles que não retornaram. Ele percebeu que as áreas sem danos nos sobreviventes eram, na verdade, os pontos mais críticos, pois quando atingidos, resultavam na perda da aeronave.

Como evitar?

- Inclua dados de falhas: Certifique-se de que o conjunto de dados contém exemplos de casos que não deram certo, além dos bem-sucedidos.

- Análise de cenários adversos: Considere diferentes cenários, incluindo aqueles em que o modelo pode falhar, para entender melhor os riscos.

- Diversidade de dados: Garanta que os dados representem toda a gama de possíveis resultados, não apenas os positivos.

5. Viés de Confirmação (Confirmation Bias)

O viés de confirmação ocorre quando cientistas de dados (ou até mesmo os dados em si) reforçam crenças pré-existentes, levando a modelos que refletem preconceitos em vez de realidade.

Um modelo de contratação que privilegia candidatos de determinadas universidades pode estar reforçando um viés inconsciente da empresa, sem avaliar objetivamente o desempenho dos profissionais.

Como evitar?

- Auditorias de modelos: Realize auditorias regulares para identificar padrões enviesados nos dados e nas previsões do modelo.

- Teste de hipóteses alternativas: Explore diferentes abordagens e variáveis para evitar o reforço de crenças prévias.

- Diversidade na equipe: Equipes diversas tendem a identificar vieses com mais facilidade, trazendo perspectivas diferentes para o desenvolvimento do modelo.

6. Viés Algorítmico (Algorithmic Bias)

O viés algorítmico é introduzido pelo próprio algoritmo, que pode amplificar desigualdades ou discriminação presentes nos dados de treinamento.

Sistemas de reconhecimento facial que funcionam melhor para determinadas etnias devido à falta de diversidade nos dados de treinamento, resultando em taxas de erro mais altas para grupos sub-representados.

Como evitar?

- Diversidade nos dados: Utilize bases de dados mais diversas e equilibradas para treinar o modelo.

- Métricas de fairness: Acompanhe métricas de desempenho para diferentes grupos, garantindo que o modelo seja justo para todos.

- Ferramentas de detecção de viés: Utilize ferramentas como IBM AI Fairness 360 e Google’s What-If Tool para identificar e mitigar vieses.

Como Mitigar Vieses em Machine Learning?

Agora que você conhece os principais tipos de viés, veja algumas estratégias práticas para reduzir esses problemas:

✅ Diversifique os dados

Garanta que seu conjunto de treinamento represente a realidade de forma abrangente, incluindo diferentes grupos, cenários e variáveis relevantes.

✅ Monitore a performance

Avalie o impacto das previsões para diferentes grupos, utilizando métricas específicas para medir a justiça (fairness) do modelo.

✅ Utilize ferramentas de fairness

Ferramentas como IBM AI Fairness 360, Google’s What-If Tool e Fairlearn podem ajudar na detecção e mitigação de vieses.

✅ Reavalie continuamente

Modelos podem desenvolver viés ao longo do tempo devido a mudanças nos dados ou no ambiente. Realize revisões periódicas para garantir que o modelo continue justo e preciso.

Conclusão

Os vieses em machine learning são um desafio significativo que pode comprometer a eficácia dos modelos e gerar impactos negativos em diversas áreas. Cientistas de dados devem estar atentos a esses problemas, adotando práticas que promovam a justiça, a transparência e a precisão dos modelos.

Ao diversificar os dados, monitorar o desempenho e utilizar ferramentas especializadas, é possível desenvolver modelos mais robustos e éticos. A luta contra o viés é contínua, mas essencial para garantir que a inteligência artificial beneficie a todos de forma equitativa.

Quer aprofundar mais no tema? Deixe seu comentário ou compartilhe este artigo com sua equipe!

Recomendação de livros para inpulsionar sua carreira

- Mãos à obra aprendizado de máquina com Scikit-Learn, Keras & TensorFlow: conceitos, ferramentas e técnicas para a construção de sistemas inteligentes.

- Python para análise de dados

- Estatística Prática Para Cientistas de Dados: 50 Conceitos Essenciais

- An Introduction to Statistical Learning (Python e R)